En matemática, una matriz es un arreglo bidimensional de números, y en su mayor generalidad de elementos de un anillo. Las matrices se usan generalmente para describir sistemas de ecuaciones lineales, sistemas de ecuaciones diferenciales o representar una aplicación lineal (dada una base). Las matrices se describen en el campo de la teoría de matrices.

Las matrices se utilizan para múltiples aplicaciones y sirven, en particular, para representar los coeficientes de los sistemas de ecuaciones lineales o para representar las aplicaciones lineales; en este último caso las matrices desempeñan el mismo papel que los datos de un vector para las aplicaciones lineales.

Pueden sumarse, multiplicarse y descomponerse de varias formas, lo que también las hace un concepto clave en el campo del álgebra lineal.

HISTORIA.

El origen de las matrices es muy antiguo. Los cuadrados latinos y los cuadrados mágicos se estudiaron desde hace mucho tiempo. Un cuadrado mágico, 3 por 3, se registra en la literatura china hacia el 650 a. C.2

Es larga la historia del uso de las matrices para resolver ecuaciones lineales. Un importante texto matemáticochino que proviene del año 300 a. C. a 200 a. C., Nueve capítulos sobre el Arte de las matemáticas (Jiu Zhang Suan Shu), es el primer ejemplo conocido de uso del método de matrices para resolver un sistema de ecuaciones simultáneas.3 En el capítulo séptimo, "Ni mucho ni poco", el concepto de determinante apareció por primera vez, dos mil años antes de su publicación por el matemático japonés Seki Kōwa en 1683 y el matemático alemánGottfried Leibniz en 1693.

Los "cuadrados mágicos" eran conocidos por los matemáticos árabes, posiblemente desde comienzos del siglo VII, quienes a su vez pudieron tomarlos de los matemáticos y astrónomos de la India, junto con otros aspectos de las matemáticas combinatorias. Todo esto sugiere que la idea provino de China. Los primeros "cuadrados mágicos" de orden 5 y 6 aparecieron en Bagdad en el 983, en la Enciclopedia de la Hermandad de Pureza (Rasa'il Ihkwan al-Safa).2

Después del desarrollo de la teoría de determinantes por Seki Kowa y Leibniz para facilitar la resolución de ecuaciones lineales, a finales del siglo XVII, Cramer presentó en 1750 la ahora denominada regla de Cramer. Carl Friedrich Gauss y Wilhelm Jordan desarrollaron la eliminación de Gauss-Jordan en el siglo XIX.

Fue James Joseph Sylvester quien utilizó por primera vez el término « matriz » en 1848/1850.

En 1853, Hamilton hizo algunos aportes a la teoría de matrices. Cayley introdujo en 1858 la notación matricial, como forma abreviada de escribir un sistema de m ecuaciones lineales con nincógnitas.

Cayley, Hamilton, Hermann Grassmann, Frobenius, Olga Taussky-Todd y John von Neumann cuentan entre los matemáticos famosos que trabajaron sobre la teoría de las matrices. En 1925,Werner Heisenberg redescubre el cálculo matricial fundando una primera formulación de lo que iba a pasar a ser la mecánica cuántica. Se le considera a este respecto como uno de los padres de la mecánica cuántica.

DEFINICIÓN Y NOTACIÓN.

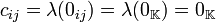

Una matriz es un arreglo bidimensional de números (llamados entradas de la matriz) ordenados en filas (o renglones) y columnas, donde una fila es cada una de las líneas horizontales de la matriz y una columna es cada una de las líneas verticales. A una matriz con n filas y m columnas se le denomina matriz n-por-m (escrito  ) donde

) donde  . El conjunto de las matrices de tamaño

. El conjunto de las matrices de tamaño  se representa como

se representa como  , donde

, donde  es el campo al cual pertenecen las entradas. El tamaño de una matriz siempre se da con el número de filas primero y el número de columnas después. Dos matrices se dice que son iguales si tienen el mismo tamaño y los mismos elementos en las mismas posiciones.

es el campo al cual pertenecen las entradas. El tamaño de una matriz siempre se da con el número de filas primero y el número de columnas después. Dos matrices se dice que son iguales si tienen el mismo tamaño y los mismos elementos en las mismas posiciones.

) donde

) donde  . El conjunto de las matrices de tamaño

. El conjunto de las matrices de tamaño  se representa como

se representa como  , donde

, donde  es el campo al cual pertenecen las entradas. El tamaño de una matriz siempre se da con el número de filas primero y el número de columnas después. Dos matrices se dice que son iguales si tienen el mismo tamaño y los mismos elementos en las mismas posiciones.

es el campo al cual pertenecen las entradas. El tamaño de una matriz siempre se da con el número de filas primero y el número de columnas después. Dos matrices se dice que son iguales si tienen el mismo tamaño y los mismos elementos en las mismas posiciones.

A la entrada de una matriz que se encuentra en la fila  ésima y la columna

ésima y la columna  ésima se le llama entrada

ésima se le llama entrada  o entrada

o entrada  -ésimo de la matriz. En estas expresiones también se consideran primero las filas y después las columnas.

-ésimo de la matriz. En estas expresiones también se consideran primero las filas y después las columnas.

ésima y la columna

ésima y la columna  ésima se le llama entrada

ésima se le llama entrada  o entrada

o entrada  -ésimo de la matriz. En estas expresiones también se consideran primero las filas y después las columnas.

-ésimo de la matriz. En estas expresiones también se consideran primero las filas y después las columnas.

Casi siempre se denotan a las matrices con letras mayúsculas mientras que se utilizan las correspondientes letras en minúsculas para denotar las entradas de las mismas. Por ejemplo, al elemento de una matriz  de tamaño

de tamaño  que se encuentra en la fila

que se encuentra en la fila  ésima y la columna

ésima y la columna  ésima se le denota como

ésima se le denota como  , donde

, donde  y

y  . Cuando se va a representar explícitamente una entrada la cuál está indexada con un

. Cuando se va a representar explícitamente una entrada la cuál está indexada con un  o un

o un  con dos cifras se introduce una coma entre el índice de filas y de columnas. Así por ejemplo, la entrada que está en la primera fila y la segunda columna de la matriz

con dos cifras se introduce una coma entre el índice de filas y de columnas. Así por ejemplo, la entrada que está en la primera fila y la segunda columna de la matriz  de tamaño

de tamaño  se representa como

se representa como  mientras que la entrada que está en la fila número 23 y la columna 100 se representa como

mientras que la entrada que está en la fila número 23 y la columna 100 se representa como .

.

de tamaño

de tamaño  que se encuentra en la fila

que se encuentra en la fila  ésima y la columna

ésima y la columna  ésima se le denota como

ésima se le denota como  , donde

, donde  y

y  . Cuando se va a representar explícitamente una entrada la cuál está indexada con un

. Cuando se va a representar explícitamente una entrada la cuál está indexada con un  o un

o un  con dos cifras se introduce una coma entre el índice de filas y de columnas. Así por ejemplo, la entrada que está en la primera fila y la segunda columna de la matriz

con dos cifras se introduce una coma entre el índice de filas y de columnas. Así por ejemplo, la entrada que está en la primera fila y la segunda columna de la matriz  de tamaño

de tamaño  se representa como

se representa como  mientras que la entrada que está en la fila número 23 y la columna 100 se representa como

mientras que la entrada que está en la fila número 23 y la columna 100 se representa como .

.

Además de utilizar letras mayúsculas para representar matrices, numerosos autores representan a las matrices con fuentes en negrita para distinguirlas de otros objetos matemáticos. Así  es una matriz, mientras que

es una matriz, mientras que  es un escalar en esa notación. Sin embargo ésta notación generalmente se deja para libros y publicaciones, donde es posible hacer ésta distinción tipográfica con facilidad. En otras notaciones se considera que el contexto es lo suficientemente claro como para no usar negritas.

es un escalar en esa notación. Sin embargo ésta notación generalmente se deja para libros y publicaciones, donde es posible hacer ésta distinción tipográfica con facilidad. En otras notaciones se considera que el contexto es lo suficientemente claro como para no usar negritas.

es una matriz, mientras que

es una matriz, mientras que  es un escalar en esa notación. Sin embargo ésta notación generalmente se deja para libros y publicaciones, donde es posible hacer ésta distinción tipográfica con facilidad. En otras notaciones se considera que el contexto es lo suficientemente claro como para no usar negritas.

es un escalar en esa notación. Sin embargo ésta notación generalmente se deja para libros y publicaciones, donde es posible hacer ésta distinción tipográfica con facilidad. En otras notaciones se considera que el contexto es lo suficientemente claro como para no usar negritas.

Otra notación, en si un abuso de notación, representa a la matriz por sus entradas, i.e.  o incluso

o incluso  .

.

o incluso

o incluso  .

.

Otra definición, muy usada en la solución de sistemas de ecuaciones lineales, es la de vectores fila y vectores columna. Un vector fila o vector renglón es cualquier matriz de tamaño  mientras que un vector columna es cualquier matriz de tamaño

mientras que un vector columna es cualquier matriz de tamaño  .

.

mientras que un vector columna es cualquier matriz de tamaño

mientras que un vector columna es cualquier matriz de tamaño  .

.

A las matrices que tienen el mismo número de filas que de columnas,  , se les llama matrices cuadradas y el conjunto se denota

, se les llama matrices cuadradas y el conjunto se denota  o alternativamente

o alternativamente  .

.

, se les llama matrices cuadradas y el conjunto se denota

, se les llama matrices cuadradas y el conjunto se denota  o alternativamente

o alternativamente  .

.

EJEMPLO.

Dada la matriz

es una matriz de tamaño  . La entrada

. La entrada  es 7.

es 7.

. La entrada

. La entrada  es 7.

es 7.

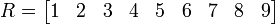

La matriz

es una matriz de tamaño  : un vector fila con 9 entradas.

: un vector fila con 9 entradas.

: un vector fila con 9 entradas.

: un vector fila con 9 entradas.

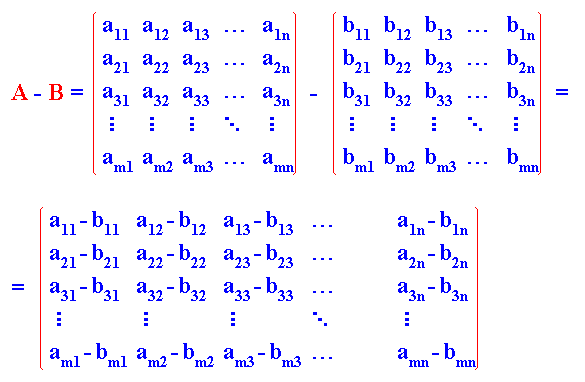

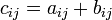

SUMA O ADICIÓN.

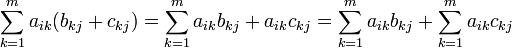

Sean  . Se define la operación de suma o adición de matrices como una operación binaria

. Se define la operación de suma o adición de matrices como una operación binaria  tal que

tal que  y donde

y donde  en el que la operación de suma en la última expresión es la operación binaria correspondiente pero en el campo

en el que la operación de suma en la última expresión es la operación binaria correspondiente pero en el campo  . Por ejemplo, la entrada

. Por ejemplo, la entrada  es igual a la suma de los elementos

es igual a la suma de los elementos  y

y  lo cual es

lo cual es  .

.

. Se define la operación de suma o adición de matrices como una operación binaria

. Se define la operación de suma o adición de matrices como una operación binaria  tal que

tal que  y donde

y donde  en el que la operación de suma en la última expresión es la operación binaria correspondiente pero en el campo

en el que la operación de suma en la última expresión es la operación binaria correspondiente pero en el campo  . Por ejemplo, la entrada

. Por ejemplo, la entrada  es igual a la suma de los elementos

es igual a la suma de los elementos  y

y  lo cual es

lo cual es  .

.

Veamos un ejemplo más explícito. Sea

No es necesario que las matrices sean cuadradas:

A la luz de éstos ejemplos es inmediato ver que dos matrices se pueden sumar solamente si ambas tienen el mismo tamaño. La suma de matrices en el caso de que las entradas estén en uncampo serán la asociatividad, la conmutatividad, existencia de elemento neutro aditivo y existencia de inverso aditivo. Ésto es así ya que éstas son propiedades de los campos en los que están las entradas de la matriz. A continuación se presentan las propiedades.

PROPIEDADES.

Sean  , donde

, donde  es un campo entonces se cumplen las siguientes propiedades para la operación binaria

es un campo entonces se cumplen las siguientes propiedades para la operación binaria

, donde

, donde  es un campo entonces se cumplen las siguientes propiedades para la operación binaria

es un campo entonces se cumplen las siguientes propiedades para la operación binaria

- Asociatividad

Demostración. Dada la definición de la operación binaria  se sigue el resultado ya que

se sigue el resultado ya que  debido a que

debido a que  para todo

para todo  .

.

se sigue el resultado ya que

se sigue el resultado ya que  debido a que

debido a que  para todo

para todo  .

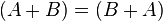

.- Conmutatividad

Demostración Dada la definición de la operación binaria  se sigue el resultado ya que

se sigue el resultado ya que  debido a que

debido a que  para todo

para todo  .

.

se sigue el resultado ya que

se sigue el resultado ya que  debido a que

debido a que  para todo

para todo  .

.- Existencia del elemento neutro aditivo

Existe  tal que

tal que

tal que

tal que

Demostración Tómese  tal que

tal que  para cualquier

para cualquier  (dónde este último es el elemento neutro aditivo en el campo, el cual existe necesariamente). Entonces para cualquier

(dónde este último es el elemento neutro aditivo en el campo, el cual existe necesariamente). Entonces para cualquier  se sigue que

se sigue que  ya que

ya que  para cualquier

para cualquier  , dado que las entradas están en un campo.

, dado que las entradas están en un campo.

tal que

tal que  para cualquier

para cualquier  (dónde este último es el elemento neutro aditivo en el campo, el cual existe necesariamente). Entonces para cualquier

(dónde este último es el elemento neutro aditivo en el campo, el cual existe necesariamente). Entonces para cualquier  se sigue que

se sigue que  ya que

ya que  para cualquier

para cualquier  , dado que las entradas están en un campo.

, dado que las entradas están en un campo.- Existencia del inverso aditivo

Existe  tal que

tal que

tal que

tal que

a esta matriz  se le denota por

se le denota por  .

.

se le denota por

se le denota por  .

.

Demostración Dada  tómese

tómese  tal que

tal que  . Entonces

. Entonces  ; luego, por las propiedades de campo

; luego, por las propiedades de campo  donde

donde  es el inverso aditivo de

es el inverso aditivo de  en el campo para cualquier

en el campo para cualquier  .

.

tómese

tómese  tal que

tal que  . Entonces

. Entonces  ; luego, por las propiedades de campo

; luego, por las propiedades de campo  donde

donde  es el inverso aditivo de

es el inverso aditivo de  en el campo para cualquier

en el campo para cualquier  .

.

En efecto, éstas propiedades dependen el conjunto en el que estén las entradas, como se ha dicho antes, aunque en las aplicaciones generalmente los campos usados son  (los números reales) y

(los números reales) y  (los números complejos).

(los números complejos).

(los números reales) y

(los números reales) y  (los números complejos).

(los números complejos).

Por como se definió la operación binaria adición se dice que ésta operación es una operación interna por lo que se cumple intrínsecamente la propiedad de que  es cerrado bajo adición. Con éstas propiedades se tiene que

es cerrado bajo adición. Con éstas propiedades se tiene que  es un grupo abeliano.

es un grupo abeliano.

es cerrado bajo adición. Con éstas propiedades se tiene que

es cerrado bajo adición. Con éstas propiedades se tiene que  es un grupo abeliano.

es un grupo abeliano.

En el caso en que el conjunto al que pertenecen las entradas de la matriz sea un anillo  , la operación de adición de matrices continúa dotando de estructura de grupo abeliano a

, la operación de adición de matrices continúa dotando de estructura de grupo abeliano a  , ya que bajo un anillo

, ya que bajo un anillo  se tiene que

se tiene que  es un grupo abeliano. En el caso de que las entradas estén en un grupo

es un grupo abeliano. En el caso de que las entradas estén en un grupo  , éste necesita ser ungrupo abeliano para que la adición de matrices siga dotando de estructura de grupo abeliano a

, éste necesita ser ungrupo abeliano para que la adición de matrices siga dotando de estructura de grupo abeliano a  .

.

, la operación de adición de matrices continúa dotando de estructura de grupo abeliano a

, la operación de adición de matrices continúa dotando de estructura de grupo abeliano a  , ya que bajo un anillo

, ya que bajo un anillo  se tiene que

se tiene que  es un grupo abeliano. En el caso de que las entradas estén en un grupo

es un grupo abeliano. En el caso de que las entradas estén en un grupo  , éste necesita ser ungrupo abeliano para que la adición de matrices siga dotando de estructura de grupo abeliano a

, éste necesita ser ungrupo abeliano para que la adición de matrices siga dotando de estructura de grupo abeliano a  .

.

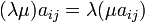

PRODUCTO POR ESCALAR.

Sean  y

y  . Se define la operación de producto por un escalar como una función

. Se define la operación de producto por un escalar como una función  tal que

tal que  y donde

y donde  en donde el producto es la operación binaria correspondiente pero en el campo

en donde el producto es la operación binaria correspondiente pero en el campo  . Por ejemplo, la entrada

. Por ejemplo, la entrada  es igual al producto

es igual al producto  .

.

y

y  . Se define la operación de producto por un escalar como una función

. Se define la operación de producto por un escalar como una función  tal que

tal que  y donde

y donde  en donde el producto es la operación binaria correspondiente pero en el campo

en donde el producto es la operación binaria correspondiente pero en el campo  . Por ejemplo, la entrada

. Por ejemplo, la entrada  es igual al producto

es igual al producto  .

.

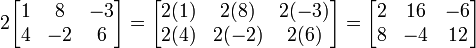

Veamos un ejemplo más explícito. Sea  y

y

y

y

También es inmediato observar que el producto por un escalar da como resultado una matriz del mismo tamaño que la original. También el producto por un escalar dependerá de la estructura algebraica en la que las entradas están. En el caso de que estén en un campo serán dos distributividades (una respecto de suma de matrices y otra respecto de suma en el campo), asociatividad y una propiedad concerniente al producto por el elemento neutro multiplicativo del campo. A continuación se presentan las propiedades.

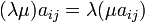

PROPIEDADES

Sean  y

y  , donde

, donde  es un campo, entonces se cumplen las siguientes propiedades para la operación producto por un escalar

es un campo, entonces se cumplen las siguientes propiedades para la operación producto por un escalar

y

y  , donde

, donde  es un campo, entonces se cumplen las siguientes propiedades para la operación producto por un escalar

es un campo, entonces se cumplen las siguientes propiedades para la operación producto por un escalar- Asociatividad

Demostración. Dada la definición de la operación se sigue el resultado ya que  debido a que

debido a que  para todo

para todo  .

.

debido a que

debido a que  para todo

para todo  .

.- Distributividad respecto de la suma de matrices

Demostración Dada la definición de la operación se sigue el resultado ya que  debido a que

debido a que  para todo

para todo  .

.

debido a que

debido a que  para todo

para todo  .

.- Distributividad respecto de la suma en el campo

Demostración Dada la definición de la operación se sigue el resultado ya que  debido a que

debido a que  para todo

para todo  .

.

debido a que

debido a que  para todo

para todo  .

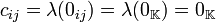

.- Producto por el neutro multiplicativo del campo

Demostración Dada la definición de la operación se sigue el resultado ya que  debido a que

debido a que  para todo

para todo  .

.

debido a que

debido a que  para todo

para todo  .

.

Por como se definió la operación de producto por escalares se dice que  es cerrado bajo producto por escalares. Con éstas propiedades y las de la adición se tiene que

es cerrado bajo producto por escalares. Con éstas propiedades y las de la adición se tiene que  es un espacio vectorial con las operaciones de suma y producto por escalares definidas antes.

es un espacio vectorial con las operaciones de suma y producto por escalares definidas antes.

es cerrado bajo producto por escalares. Con éstas propiedades y las de la adición se tiene que

es cerrado bajo producto por escalares. Con éstas propiedades y las de la adición se tiene que  es un espacio vectorial con las operaciones de suma y producto por escalares definidas antes.

es un espacio vectorial con las operaciones de suma y producto por escalares definidas antes.

En el caso de que las entradas y los escalares no estén en un campo sino en un anillo entonces no necesariamente existe el neutro multiplicativo. En caso de que exista, con lo cual el anillo es un anillo con uno, se dice que  es un módulo sobre

es un módulo sobre  .

.

es un módulo sobre

es un módulo sobre  .

.

Ahora, a partir de las propiedades básicas se puede demostrar inmediatamente que

Demostración Dada la definición de la operación se sigue el resultado ya que  para todo

para todo  .

.

para todo

para todo  .

.

Demostración Dada la definición de la operación se sigue el resultado ya que  para todo

para todo  debido a que

debido a que  para todo

para todo  .

.

para todo

para todo  debido a que

debido a que  para todo

para todo  .

.

Demostración Dada la definición de la operación se sigue el resultado ya que como en un campo no hay divisores de cero entonces  para todo

para todo  implica que

implica que  o

o  para todo

para todo  , i.e.

, i.e.  . No es posible un caso en el que sólo algunas entradas de la matriz sean cero y el escalar sea no nulo ya que en esos casos estaríamos diciendo que hay divisores de cero y llegaríamos a una contradicción, ya que la suposición es que las entradas y los escalares están en un campo.

. No es posible un caso en el que sólo algunas entradas de la matriz sean cero y el escalar sea no nulo ya que en esos casos estaríamos diciendo que hay divisores de cero y llegaríamos a una contradicción, ya que la suposición es que las entradas y los escalares están en un campo.

para todo

para todo  implica que

implica que  o

o  para todo

para todo  , i.e.

, i.e.  . No es posible un caso en el que sólo algunas entradas de la matriz sean cero y el escalar sea no nulo ya que en esos casos estaríamos diciendo que hay divisores de cero y llegaríamos a una contradicción, ya que la suposición es que las entradas y los escalares están en un campo.

. No es posible un caso en el que sólo algunas entradas de la matriz sean cero y el escalar sea no nulo ya que en esos casos estaríamos diciendo que hay divisores de cero y llegaríamos a una contradicción, ya que la suposición es que las entradas y los escalares están en un campo.

Demostración Dada la definición de la operación se sigue el resultado ya que  debido a que

debido a que  para todo

para todo  .

.

debido a que

debido a que  para todo

para todo  .

.

Este último resultado permite usar la notación  sin riesgo de ambigüedad.

sin riesgo de ambigüedad.

sin riesgo de ambigüedad.

sin riesgo de ambigüedad.

PRODUCTO.

El producto de matrices se define de una manera muy peculiar y hasta caprichosa cuando no se conoce su origen. El origen proviene del papel de las matrices como representaciones de aplicaciones lineales. Así el producto de matrices, como se define, proviene de la composición de aplicaciones lineales. En este contexto, el tamaño de la matriz corresponde con las dimensiones de los espacios vectoriales entre los cuales se establece la aplicación lineal. De ese modo el producto de matrices, representa la composición de aplicaciones lineales.

En efecto, en ciertas bases tenemos que  se puede representar como

se puede representar como  donde

donde  es la representación de un vector de

es la representación de un vector de  en la base que se ha elegido para

en la base que se ha elegido para  en forma de vector columna. Si tenemos dos aplicaciones lineales

en forma de vector columna. Si tenemos dos aplicaciones lineales  y

y  entonces

entonces  y

y  , luego la aplicación

, luego la aplicación  se representará como

se representará como  donde

donde  es el producto de las representaciones matriciales de

es el producto de las representaciones matriciales de  . Nótese que la composición no se puede dar entre cualquier aplicación sino entre aplicaciones que vayan de

. Nótese que la composición no se puede dar entre cualquier aplicación sino entre aplicaciones que vayan de  , en particular debe de haber una relación entre las dimensiones de los espacios vectoriales. Una vez dicho ésto podemos definir el producto de la siguiente manera.

, en particular debe de haber una relación entre las dimensiones de los espacios vectoriales. Una vez dicho ésto podemos definir el producto de la siguiente manera.

se puede representar como

se puede representar como  donde

donde  es la representación de un vector de

es la representación de un vector de  en la base que se ha elegido para

en la base que se ha elegido para  en forma de vector columna. Si tenemos dos aplicaciones lineales

en forma de vector columna. Si tenemos dos aplicaciones lineales  y

y  entonces

entonces  y

y  , luego la aplicación

, luego la aplicación  se representará como

se representará como  donde

donde  es el producto de las representaciones matriciales de

es el producto de las representaciones matriciales de  . Nótese que la composición no se puede dar entre cualquier aplicación sino entre aplicaciones que vayan de

. Nótese que la composición no se puede dar entre cualquier aplicación sino entre aplicaciones que vayan de  , en particular debe de haber una relación entre las dimensiones de los espacios vectoriales. Una vez dicho ésto podemos definir el producto de la siguiente manera.

, en particular debe de haber una relación entre las dimensiones de los espacios vectoriales. Una vez dicho ésto podemos definir el producto de la siguiente manera.

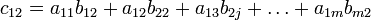

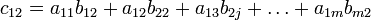

Sean  y

y  . Se define el producto de matrices como una función

. Se define el producto de matrices como una función  tal que

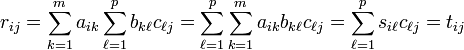

tal que  y donde

y donde  para toda

para toda  , es decir

, es decir  . Por ejemplo, la entrada

. Por ejemplo, la entrada  .

.

y

y  . Se define el producto de matrices como una función

. Se define el producto de matrices como una función  tal que

tal que  y donde

y donde  para toda

para toda  , es decir

, es decir  . Por ejemplo, la entrada

. Por ejemplo, la entrada  .

.

Veamos un ejemplo más explícito. Sean  y

y

y

y

dónde la matriz producto es como habíamos establecido en la definición: una matriz  .

.

.

.

Sin tomar en cuenta la motivación que viene desde las aplicaciones lineales, es evidente ver que si ignoramos la definición de la función de producto de matrices y sólo se toma en cuenta la definición de las entradas, el producto no estará bien definido, ya que si  no tiene el mismo número de columnas que

no tiene el mismo número de columnas que  de filas entonces no podremos establecer en donde acaba la suma: si la acabamos en el mayor de éstos números habrá sumandos que no están definidos ya que una de las matrices no tendrá mas entradas, mientras que si tomamos el menor habrá entradas de alguna de las matrices que no se tomen en cuenta. Así es necesario que

de filas entonces no podremos establecer en donde acaba la suma: si la acabamos en el mayor de éstos números habrá sumandos que no están definidos ya que una de las matrices no tendrá mas entradas, mientras que si tomamos el menor habrá entradas de alguna de las matrices que no se tomen en cuenta. Así es necesario que  tenga el mismo número de columnas que

tenga el mismo número de columnas que  de filas para que

de filas para que  exista.

exista.

no tiene el mismo número de columnas que

no tiene el mismo número de columnas que  de filas entonces no podremos establecer en donde acaba la suma: si la acabamos en el mayor de éstos números habrá sumandos que no están definidos ya que una de las matrices no tendrá mas entradas, mientras que si tomamos el menor habrá entradas de alguna de las matrices que no se tomen en cuenta. Así es necesario que

de filas entonces no podremos establecer en donde acaba la suma: si la acabamos en el mayor de éstos números habrá sumandos que no están definidos ya que una de las matrices no tendrá mas entradas, mientras que si tomamos el menor habrá entradas de alguna de las matrices que no se tomen en cuenta. Así es necesario que  tenga el mismo número de columnas que

tenga el mismo número de columnas que  de filas para que

de filas para que  exista.

exista.

Como se puede suponer también, las propiedades de ésta operación serán más limitadas en la generalidad ya que además de las limitaciones impuestas por la naturaleza de las entradas está esta limitación respecto a tamaño. Es claro, además, que el producto de matrices no siempre es una operación interna.

PROPIEDADES.

Sean  matrices con entradas en

matrices con entradas en  , donde

, donde  es un campo, entonces se cumplen las siguientes propiedades para el producto de matrices (considerando que los productos existan)

es un campo, entonces se cumplen las siguientes propiedades para el producto de matrices (considerando que los productos existan)

matrices con entradas en

matrices con entradas en  , donde

, donde  es un campo, entonces se cumplen las siguientes propiedades para el producto de matrices (considerando que los productos existan)

es un campo, entonces se cumplen las siguientes propiedades para el producto de matrices (considerando que los productos existan)- Asociatividad

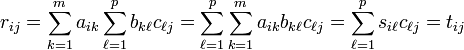

Demostración. Dada la definición de la operación se sigue el resultado ya que, si  ,

,  y

y  por lo que

por lo que  donde

donde  debido a que

debido a que  para todo

para todo  . Aquí estamos considerando que

. Aquí estamos considerando que  es

es  ,

,  es

es  y

y  es

es  .

.

,

,  y

y  por lo que

por lo que  donde

donde  debido a que

debido a que  para todo

para todo  . Aquí estamos considerando que

. Aquí estamos considerando que  es

es  ,

,  es

es  y

y  es

es  .

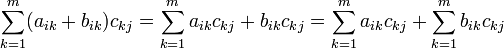

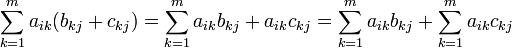

.- Distributividad respecto de la suma de matrices por la derecha

Demostración Dada la definición de la operación se sigue el resultado ya que  debido a que

debido a que  para todo

para todo  . Aquí estamos considerando que

. Aquí estamos considerando que  es

es  ,

,  es

es  y

y  es

es  .

.

debido a que

debido a que  para todo

para todo  . Aquí estamos considerando que

. Aquí estamos considerando que  es

es  ,

,  es

es  y

y  es

es  .

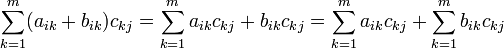

.- Distributividad respecto de la suma de matrices por la izquierda

Demostración Dada la definición de la operación se sigue el resultado ya que  debido a que

debido a que  para todo

para todo  . Aquí estamos considerando que

. Aquí estamos considerando que  es

es  ,

,  es

es  y

y  es

es  .

.

debido a que

debido a que  para todo

para todo  . Aquí estamos considerando que

. Aquí estamos considerando que  es

es  ,

,  es

es  y

y  es

es  .

.

El producto de matrices no es conmutativo, si lo fuera la composición de funciones lineales sería conmutativa y eso en general no sucede. Obviamente existen casos particulares de algunos tipos de matrices en los que si hay conmutatividad. En el caso en que tengamos  tendremos que el producto entre matrices en

tendremos que el producto entre matrices en  también está en

también está en  . En ese caso

. En ese caso  además de espacio vectorial es un álgebra sobre un campo. En el caso de que el conjunto al que pertenecen las entradas sea un anillo conmutativo con uno entonces

además de espacio vectorial es un álgebra sobre un campo. En el caso de que el conjunto al que pertenecen las entradas sea un anillo conmutativo con uno entonces  además de módulo es un álgebra sobre un anillo. Mas aún

además de módulo es un álgebra sobre un anillo. Mas aún  con

con  el producto de matrices es un anillo.

el producto de matrices es un anillo.

tendremos que el producto entre matrices en

tendremos que el producto entre matrices en  también está en

también está en  . En ese caso

. En ese caso  además de espacio vectorial es un álgebra sobre un campo. En el caso de que el conjunto al que pertenecen las entradas sea un anillo conmutativo con uno entonces

además de espacio vectorial es un álgebra sobre un campo. En el caso de que el conjunto al que pertenecen las entradas sea un anillo conmutativo con uno entonces  además de módulo es un álgebra sobre un anillo. Mas aún

además de módulo es un álgebra sobre un anillo. Mas aún  con

con  el producto de matrices es un anillo.

el producto de matrices es un anillo.

RANGO.

El rango de una matriz  es la dimensión de la imagen de la aplicación lineal representada por

es la dimensión de la imagen de la aplicación lineal representada por  , que coincide con la dimensión de los espacios vectoriales generados por las filas o columnas de

, que coincide con la dimensión de los espacios vectoriales generados por las filas o columnas de  .

.

es la dimensión de la imagen de la aplicación lineal representada por

es la dimensión de la imagen de la aplicación lineal representada por  , que coincide con la dimensión de los espacios vectoriales generados por las filas o columnas de

, que coincide con la dimensión de los espacios vectoriales generados por las filas o columnas de  .

.

TRASPUESTA.

La traspuesta de una matriz  , donde

, donde  no es necesariamente un campo, es una matriz

no es necesariamente un campo, es una matriz  tal que

tal que  . Por ejemplo la entrada

. Por ejemplo la entrada  .

.

, donde

, donde  no es necesariamente un campo, es una matriz

no es necesariamente un campo, es una matriz  tal que

tal que  . Por ejemplo la entrada

. Por ejemplo la entrada  .

.

Veamos un ejemplo más explícito. Sea

entonces su traspuesta es

Así, informalmente podríamos decir que la traspuesta es aquella matriz que se obtiene de la original cambiando filas por columnas. Las notaciones usuales para denotar la traspuesta de una matriz son  .

.

.

.

La trasposición de matrices tiene las siguientes propiedades (donde ahora si el conjunto de entradas debe ser al menos un anillo conmutativo):

Si  representa una aplicación lineal, entonces la matriz

representa una aplicación lineal, entonces la matriz  describe la traspuesta de la aplicación lineal.

describe la traspuesta de la aplicación lineal.

representa una aplicación lineal, entonces la matriz

representa una aplicación lineal, entonces la matriz  describe la traspuesta de la aplicación lineal.

describe la traspuesta de la aplicación lineal.

MATRICES CUADRADAS.

Una matriz cuadrada es una matriz que tiene el mismo número de filas que de columnas. El conjunto de todas las matrices cuadradas n-por-n junto a la suma y la multiplicación de matrices, es un anillo que generalmente no es conmutativo.

M(n,R), el anillo de las matrices cuadradas reales, es un álgebra asociativa real unitaria. M(n,C), el anillo de las matrices cuadradas complejas, es un álgebra asociativa compleja.

La matriz identidad In de orden n es la matriz n por n en la cual todos los elementos de la diagonal principal son iguales a 1 y todos los demás elementos son iguales a 0. La matriz identidad se denomina así porque satisface las ecuaciones MIn = M y InN = N para cualquier matriz M m por n y N n por k. Por ejemplo, si n = 3:

La matriz identidad es el elemento unitario en el anillo de matrices cuadradas.

Los elementos invertibles de este anillo se llaman matrices invertibles, regulares o no singulares. Una matriz A n por n es invertible si y sólo si existe una matriz B tal que

- AB = In = BA.

En este caso, B es la matriz inversa de A, identificada por A-1 . El conjunto de todas las matrices invertibles n por n forma un grupo (concretamente un grupo de Lie) bajo la multiplicación de matrices, el grupo lineal general.

Si λ es un número y v es un vector no nulo tal que Av = λv, entonces se dice que v es un vector propio de A y que λ es su valor propio asociado. El número λ es un valor propio de A si y sólo siA−λIn no es invertible, lo que sucede si y sólo si pA(λ) = 0, donde pA(x) es el polinomio característico de A. pA(x) es un polinomio de grado n y por lo tanto, tiene n raíces complejas múltiples raíces si se cuentan de acuerdo a su multiplicidad. Cada matriz cuadrada tiene como mucho n valores propios complejos.

El determinante de una matriz cuadrada A es el producto de sus n valores propios, pero también puede ser definida por la fórmula de Leibniz. Las matrices invertibles son precisamente las matrices cuyo determinante es distinto de cero.

El algoritmo de eliminación gaussiana puede ser usado para calcular el determinante, el rango y la inversa de una matriz y para resolver sistemas de ecuaciones lineales.

La traza de una matriz cuadrada es la suma de los elementos de la diagonal, lo que equivale a la suma de sus n valores propios.

Una matriz de Vandermonde es una matriz cuadrada cuyas filas son las potencias de un número. Su determinante es fácil de calcular.

No hay comentarios:

Publicar un comentario